数学的魅力在于,简单的模型可以做伟大的事情。" 现代数据科学中并不缺乏花哨的算法和技术。技术很容易学习,但也很容易落后。然而,从长远来看,数学的基础可以使人受益。协方差矩阵是一个简单而有用的数学概念,被广泛应用于金融工程、计量经济学以及机器学习。

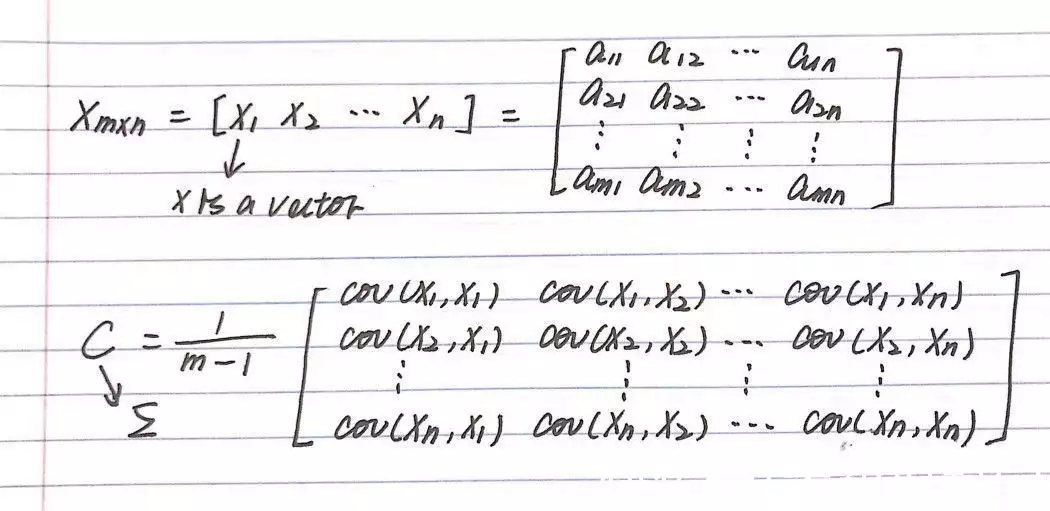

协方差衡量两个随机变量在一个总体中共同变化的程度。当总体包含更高维度或更多随机变量时,用矩阵来描述不同维度之间的关系。协方差矩阵是一种更容易理解的方式,它将整个维度中的关系定义为每两个随机变量之间的关系。

用例1:随机建模

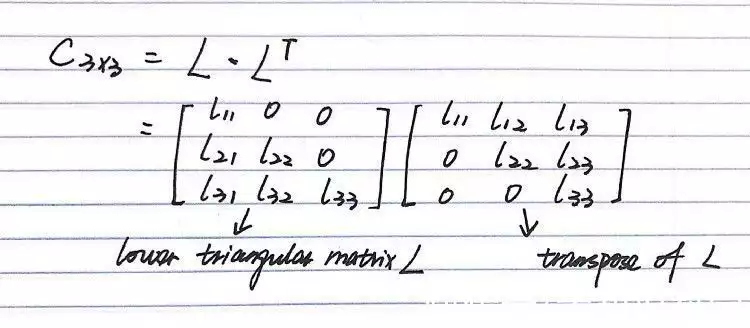

协方差矩阵最重要的特点是它是半正定的,那么久可以用乔里斯基分解了(Cholesky decomposition):

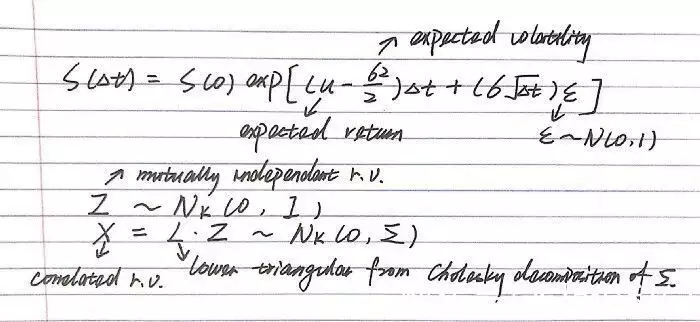

简而言之,乔里斯基分解是将一个正定矩阵分解为下三角矩阵与其转置的乘积。在实践中,人们用它来生成相关的随机变量,方法是将协方差矩阵分解成标准正态分布,然后将下三角相乘。此外,矩阵分解在很多方面都是有帮助的,因为使用隐藏因子来描述矩阵的特征,可以发现一些普遍的属性,而我们并不经常可以明确地进行矩阵计算。

在金融工程中,蒙特卡洛模拟(Monte Carlo simulation)在期权定价中发挥了很大的作用,在这种情况下,衍生品的报酬取决于一篮子的相关资产。鉴于股票价格演变的标准公式假定股票价格遵循几何布朗运动( geometric Brownian motion),通过对协方差矩阵进行乔尔斯基分解,可以计算出相关股票的价格。

用例2:主成分分析

主成分分析(PCA)是一种无监督的线性降维算法,将原始变量转化为这些独立变量的线性组合。它将整个数据集投射到一个不同的特征空间,在那里它可以优先考虑解释数据最大差异的维度。机器学习实践者利用PCA通过降低低方差维度来降低计算复杂性,并创建更好的可视化。

PCA如何与协方差相联系?特征分解

就像乔里斯基分解,特征分解是一种更直观的矩阵分解方式,通过使用其特征向量和特征值表示矩阵。特征向量的定义是:当对其进行线性变换时,仅以标量形式变化的向量。如果A是代表线性变换的矩阵,v是一个特征向量,λ是相应的特征值。它可以表示为Av =λv。一个正方形矩阵可以有多少个特征向量就有多少个维度。如果把所有的特征向量作为矩阵V的列,把相应的特征值作为对角矩阵L的条目,上述方程可以扩展为AV = VL。在协方差矩阵的情况下,所有的特征向量都是相互正交的,这就是新特征空间的主成分。通过将特征向量按其特征值从高到低的顺序排列,可以得到按重要性排列的主成分。